Graphcore 與 Hugging Face 聯袂推出全新 IPU-Ready Transformers 系列模型

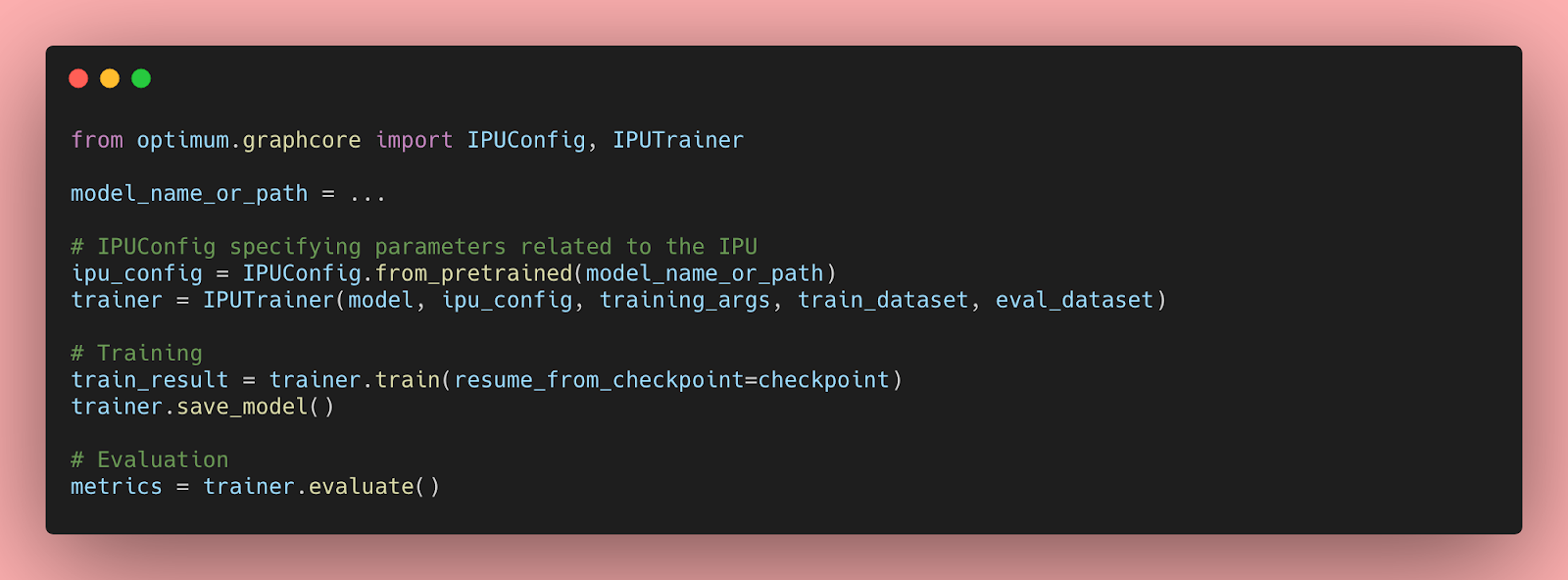

Graphcore 與 Hugging Face 顯著擴充套件了 Hugging Face Optimum 中可用的機器學習模態和任務範圍。Hugging Face Optimum 是一個用於 Transformer 效能最佳化的開源庫。現在,開發人員可以方便地訪問各種開箱即用的 Hugging Face Transformer 模型,這些模型經過最佳化,能夠在 Graphcore 的 IPU 上提供最佳效能。

繼 Optimum Graphcore 釋出後不久推出的 BERT Transformer 模型之後,開發人員現在可以訪問 10 種涵蓋自然語言處理 (NLP)、語音和計算機視覺的模型。這些模型都附帶了 IPU 配置檔案以及可隨時使用的預訓練和微調模型權重。

全新 Optimum 模型

計算機視覺

ViT (Vision Transformer) 是影像識別領域的一項突破,它使用 Transformer 機制作為其主要元件。當影像輸入 ViT 時,它們會被分成小塊,類似於語言系統中處理單詞的方式。每個小塊都由 Transformer 編碼 (嵌入),然後可以單獨處理。

自然語言處理

GPT-2 (生成式預訓練 Transformer 2) 是一個文字生成 Transformer 模型,它在一個非常大的英文語料庫上以自監督方式進行了預訓練。這意味著它僅在原始文字上進行預訓練,沒有任何人工標註 (這就是為什麼它可以使用大量公開資料),並透過一個自動化過程從這些文字中生成輸入和標籤。更準確地說,它透過猜測句子中的下一個單詞來從提示中生成文字。

RoBERTa (穩健最佳化的 BERT 方法) 是一個 Transformer 模型,它 (像 GPT-2 一樣) 在一個大型英文語料庫上以自監督方式進行了預訓練。更準確地說,RoBERTa 是使用掩碼語言建模 (MLM) 目標進行預訓練的。給定一個句子,模型會隨機掩蓋輸入中 15% 的單詞,然後將整個被掩蓋的句子輸入模型,並必須預測被掩蓋的單詞。RoBERTa 可以用於掩碼語言建模,但主要用於在下游任務上進行微調。

DeBERTa (使用解耦注意力的解碼增強 BERT) 是一個用於自然語言處理任務的預訓練神經語言模型。DeBERTa 採用了兩種新技術——解耦注意力機制和增強型掩碼解碼器——來改進 2018 年的 BERT 和 2019 年的 RoBERTa 模型,從而顯著提高了模型預訓練的效率和下游任務的效能。

BART 是一個 Transformer 編碼器-解碼器 (seq2seq) 模型,具有一個雙向 (類似 BERT) 的編碼器和一個自迴歸 (類似 GPT) 的解碼器。BART 的預訓練方式是 (1) 用任意的噪聲函式破壞文字,以及 (2) 學習一個模型來重建原始文字。BART 在針對文字生成 (例如摘要、翻譯) 進行微調時特別有效,但在理解任務 (例如文字分類、問答) 方面也表現良好。

LXMERT (從 Transformer 中學習跨模態編碼器表示) 是一個用於學習視覺和語言表示的多模態 Transformer 模型。它有三個編碼器:一個物件關係編碼器、一個語言編碼器和一個跨模態編碼器。它透過掩碼語言建模、視覺-語言文字對齊、ROI 特徵迴歸、掩碼視覺屬性建模、掩碼視覺物件建模和視覺問答等目標的組合進行預訓練。它在 VQA 和 GQA 視覺問答資料集上取得了業界最佳結果。

T5 (文字到文字遷移 Transformer) 是一個革命性的新模型,它可以將任何文字轉換為用於翻譯、問答或分類的機器學習格式。它引入了一個統一的框架,將所有基於文字的語言問題都轉換為文字到文字的格式以進行遷移學習。透過這種方式,它簡化了在各種自然語言處理任務中使用相同模型、目標函式、超引數和解碼過程的方法。

語音

HuBERT (隱藏單元 BERT) 是一個在音訊上預訓練的自監督語音識別模型,它在連續輸入上學習了一個組合的聲學和語言模型。HuBERT 模型在 Librispeech (960h) 和 Libri-light (60,000h) 基準測試中,使用 10 分鐘、1 小時、10 小時、100 小時和 960 小時微調子集,其效能與業界最先進的 wav2vec 2.0 相當或更好。

Wav2Vec2 是一個用於自動語音識別的預訓練自監督模型。Wav2Vec2 使用一種新穎的對比性預訓練目標,從大量未標記的語音資料中學習強大的語音表示,然後在少量轉錄的語音資料上進行微調,其效能優於最好的半監督方法,同時概念上更簡單。

Hugging Face Optimum Graphcore:基於堅實合作關係的再深化

Graphcore 於 2021 年作為創始成員加入了 Hugging Face 硬體合作伙伴計劃,兩家公司都懷抱著一個共同目標:為希望利用機器智慧力量的創新者們降低門檻。

自那時起,Graphcore 和 Hugging Face 廣泛合作,旨在讓在 IPU 上訓練 Transformer 模型變得既快速又簡單,首個 Optimum Graphcore 模型 (BERT) 已於去年推出。

Transformers 已被證明在廣泛的功能中非常高效,包括特徵提取、文字生成、情感分析、翻譯等等。像 BERT 這樣的模型被 Graphcore 的客戶廣泛用於各種應用,包括網路安全、語音通話自動化、藥物發現和翻譯。

在現實世界中最佳化它們的效能需要大量的時間、精力和技能,這超出了許多公司和組織的能力範圍。透過提供一個開源的 Transformer 模型庫,Hugging Face 直接解決了這些問題。將 IPU 與 Hugging Face 整合也讓開發人員不僅可以利用模型,還可以利用 Hugging Face Hub 中可用的資料集。

現在,開發人員可以使用 Graphcore 系統來訓練 10 種不同型別的業界領先 Transformer 模型,並以最少的編碼複雜性訪問數千個數據集。透過這次合作,我們為使用者提供了工具和生態系統,以便他們輕鬆下載最先進的預訓練模型,並將其微調到各種領域和下游任務。

Graphcore 最新硬體和軟體齊上陣

雖然 Hugging Face 不斷擴大的使用者群已經能夠從 IPU 技術的速度、效能以及功耗和成本效率中獲益,但 Graphcore 最近釋出的硬體和軟體組合將釋放更多潛力。

在硬體方面,於三月份釋出並現已向客戶發貨的 Bow IPU 是世界上第一款使用晶圓堆疊晶圓 (Wafer-on-Wafer, WoW) 3D 堆疊技術的處理器,將 IPU 的諸多優勢提升到了一個新的水平。憑藉在計算架構、晶片實現、通訊和記憶體方面的突破性進展,每個 Bow IPU 可提供高達 350 teraFLOPS 的 AI 計算能力——效能提升了令人矚目的 40%——並且與上一代 IPU 相比,能效提高了多達 16%。重要的是,Hugging Face Optimum 使用者可以從上一代 IPU 無縫切換到 Bow 處理器,因為無需更改任何程式碼。

軟體在釋放 IPU 的能力方面也起著至關重要的作用,因此 Optimum 自然而然地提供了與 Graphcore 易於使用的 Poplar SDK 的即插即用體驗——該 SDK 本身也迎來了 2.5 版本的重大更新。Poplar 使在最先進的硬體上訓練最先進的模型變得輕而易舉,這要歸功於它與標準機器學習框架 (包括 PyTorch、PyTorch Lightning 和 TensorFlow) 以及 Docker 和 Kubernetes 等編排和部署工具的完全整合。讓 Poplar 與這些廣泛使用的第三方系統相容,使得開發人員可以輕鬆地將他們的模型從其他計算平臺移植過來,並開始利用 IPU 先進的 AI 功能。

即刻開始體驗 Hugging Face 的 Optimum Graphcore 模型

如果您有興趣將 IPU 技術的優勢與 Transformer 模型的強大功能相結合,您可以從 Hugging Face Hub 上的 Graphcore 組織下載最新的 Optimum Graphcore 模型系列,或從 Optimum GitHub 倉庫獲取程式碼。我們的入門部落格文章將指導您完成每一步,開始體驗 IPU。

此外,Graphcore 還建立了一個內容豐富的開發者資源頁面,您可以在其中找到 IPU Model Garden——一個包含計算機視覺、自然語言處理、圖網路等可隨時部署的機器學習應用的倉庫——以及大量的文件、教程、操作影片、網路研討會等等。您還可以訪問 Graphcore 的 GitHub 倉庫獲取更多程式碼參考和教程。

要了解更多關於在 Graphcore 上使用 Hugging Face 的資訊,請訪問我們的合作伙伴頁面!