推出 ConTextual:您的多模態模型在文字豐富的場景中能多好地聯合推理文字和影像?

模型在理解獨立文字方面已經相當出色,但對於影像中的文字(提供重要的上下文資訊)呢?例如,導航地圖或理解一個表情包?對影像中文字和視覺上下文之間互動進行推理的能力可以支援許多現實世界的應用,例如AI助手或輔助視障人士的工具。

我們將這些任務稱為“上下文敏感的富文字視覺推理任務”。

目前,大多數對指令調整的大型多模態模型(LMM)的評估都集中在測試模型對影像上的提問或命令式句子(“數一下這個”、“列出那個”等)的響應能力……但未能很好地理解上下文敏感的富文字場景!

這就是為什麼我們(來自加州大學洛杉磯分校的研究人員)建立了 ConTextual,一個用於評估 LMM 的上下文敏感的富文字視覺推理資料集。我們還發布了一個排行榜,以便社群可以親自檢視哪些模型在此任務中表現最佳。

如需深入瞭解,您還可以檢視這些額外資源:論文、程式碼、資料集、驗證資料集 和 排行榜。

什麼是 ConTextual?

ConTextual 是一個上下文敏感的富文字視覺推理資料集,包含 506 條用於 LMM 評估的挑戰性指令。我們建立了文字豐富的影像上各種指令,並要求它們需要對影像中的文字和視覺線索進行上下文敏感的聯合推理。

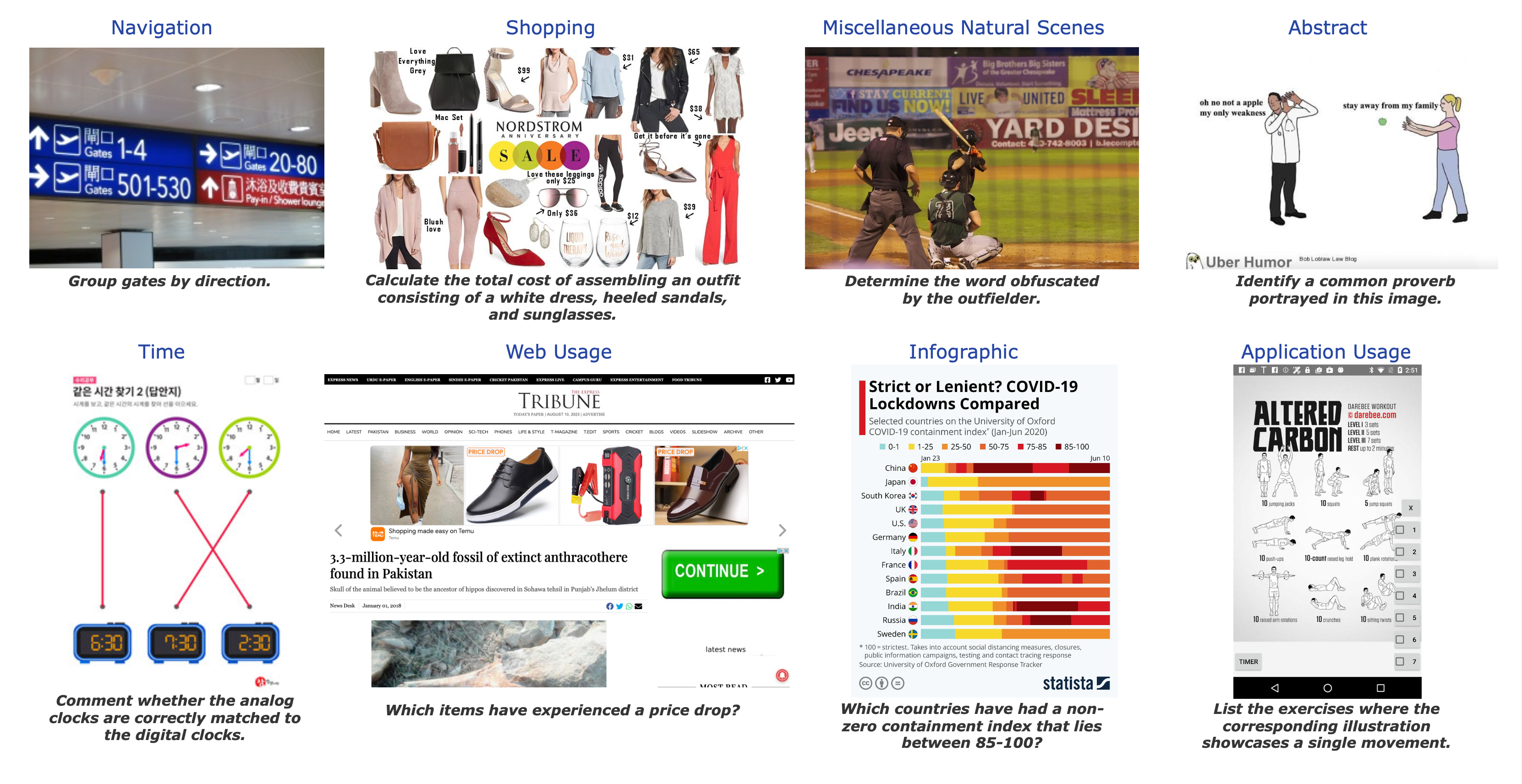

它涵蓋了 8 種現實世界的視覺場景——時間閱讀、購物、導航、抽象場景、移動應用程式、網頁、資訊圖表和雜項自然場景。(請參閱圖以獲取每個資料集的樣本。)

每個樣本包括:

- 一張文字豐富的影像

- 一條人工編寫的指令(問題或命令任務)

- 一個人工編寫的參考響應

該資料集以兩種形式釋出:

- (a) 一個包含 100 個例項的驗證集,其中包含完整資料集中的指令、影像和指令的參考答案。

- (b) 一個僅包含指令和影像的測試資料集。

排行榜包含模型在驗證和測試資料集上的結果(資訊也存在於論文中)。開發集允許實踐者輕鬆測試和迭代他們的方法。評估沙盒位於我們的 GitHub 上。

實驗

對於我們的初步實驗,我們的基準評估了 13 個模型的效能。我們將其分為三類:

- 增強型大型語言模型(LLM)方法:GPT4 + 以影像 OCR 和/或密集影像字幕形式的視覺資訊;

- 閉源大型多模態模型(LMM):GPT4V(ision) 和 Gemini-Vision-Pro;

- 開源大型多模態模型(LMM):LLaVA-v1.5-13B、ShareGPT4V-7B、Instruct-Blip-Vicuna-7B、mPlugOwl-v2-7B、Bliva-Vicuna-7B、Qwen-VL-7B 和 Idefics-9B。

我們的資料集為每條指令都包含一個參考響應,這使得我們能夠測試各種自動評估方法。對於評估,我們使用 LLM-as-a-judge 方法,並向 GPT-4 提供指令、參考響應和預測響應。模型必須返回預測響應是否可接受。(選擇 GPT4 是因為它在我們的實驗中與人類判斷的相關性最高。)

讓我們看一些例子!

示例 1 在此示例中,儘管 GPT-4V 進行了邏輯推理,但對指令給出了不正確的響應。綠色表示與參考匹配的響應,而紅色突出顯示響應中的錯誤。此外,還提供了“總結推理”以概述 GPT-4V 得出答案所使用的推理過程。

示例 2 在此示例中,GPT-4V 正確響應了指令。然而,ShareGPT-4V-7B(效能最佳的開源 LMM)和帶佈局感知 OCR + 字幕的 GPT-4(增強型 LLM)由於缺乏對文字和影像的聯合推理而產生了錯誤的響應。

您可以在我們論文的附錄部分找到更多類似的例子!

主要收穫!

在進行這項工作時,我們發現:

- 現代 LMM(專有模型和開源模型)在 ConTextual 資料集上的表現不佳,而人類則表現良好,這暗示了模型改進以增強富文字影像推理的可能性,這是一個具有重要現實世界應用的領域。

- 專有 LMM 在涉及時間閱讀的資訊圖表推理中表現不佳,表明其能力與人類相比存在差距。值得注意的是,效能最佳的模型 GPT-4V 在抽象推理方面超越了人類,這可能是由於接觸了表情包和引用資料,但在人類擅長的時間相關任務中卻表現不佳。

- 對於 LLaVA-1.5-13B 和 ShareGPT-4V-7B 等開源模型,它們在獲得可接受的人類評分的領域(抽象和自然場景上下文)與其他領域(時間閱讀、資訊圖表、導航、購物、網頁和移動使用)之間存在顯著差距。因此,我們樣本中涵蓋的許多領域很可能超出了這些模型的分佈。因此,開源模型應旨在增加其訓練資料的多樣性。

- 用大型語言模型增強 LMM,該模型透過 OCR 或字幕將視覺資訊轉換為文字,表現明顯不佳,人類批准率僅為 17.2%。我們的樣本需要精確的視覺感知與細粒度的視覺語言對齊相結合才能解決。

我們的分析表明,下一步有望實現:

- 開發增強型影像編碼器,

- 建立高度準確的影像描述,

- 促進細粒度的視覺-語言對齊,以改善模型的感知並減少幻覺的發生。

這反過來將導致更有效的上下文敏感的富文字視覺推理。

接下來是什麼?

我們也很樂意評估您的模型,以共同推動視覺語言模型的發展!要提交,請遵循以下指南。

我們希望這個基準能幫助開發細緻的視覺-語言對齊技術,並歡迎任何形式的合作!您可以透過以下方式聯絡我們:Rohan 和 Hritik,並在此處瞭解更多關於團隊的資訊:Rohan、Hritik、Kai-Wei Chang、Nanyun (Violet) Peng。

如何提交?

我們接受測試集和驗證集的提交。請遵循以下相應程式。

驗證集提交

要將您的驗證結果提交到排行榜,您可以按照這些說明執行我們的自動評估程式碼(使用 GPT4 的評估流程)。

我們希望提交的檔案為 JSON 格式,如下所示:

{"model_name": {"img_url": "The boolean score of your model on the image, 1 for success and 0 for failure"}}

- 將模型名稱替換為您的模型名稱(字串)

- 將 img_url 替換為例項的 img_url(字串)

- img_url 的值為 0 或 1(整數)

應該有 100 個預測,對應於驗證集的 100 個 URL。

要進行提交,請訪問 HuggingFace 上託管的排行榜並填寫提交表單。

測試集提交

一旦您對驗證結果滿意,您可以將您的模型預測傳送給Rohan和Hritik。

請在您的電子郵件中包含:

- 您模型的名稱。

- 組織(隸屬關係)。

- (可選)GitHub 倉庫或論文連結。

我們希望提交的格式為 JSON,類似於驗證集,如下所示:

{"model_name": {"img_url": "predicted response"}}

- 將模型名稱替換為您的模型名稱(字串)

- 將 img_url 替換為例項的 img_url(字串)

- img_url 的值是該例項的預測響應(字串)

應有 506 個預測,對應測試集的 506 個 URL。