大型語言模型:新的摩爾定律?

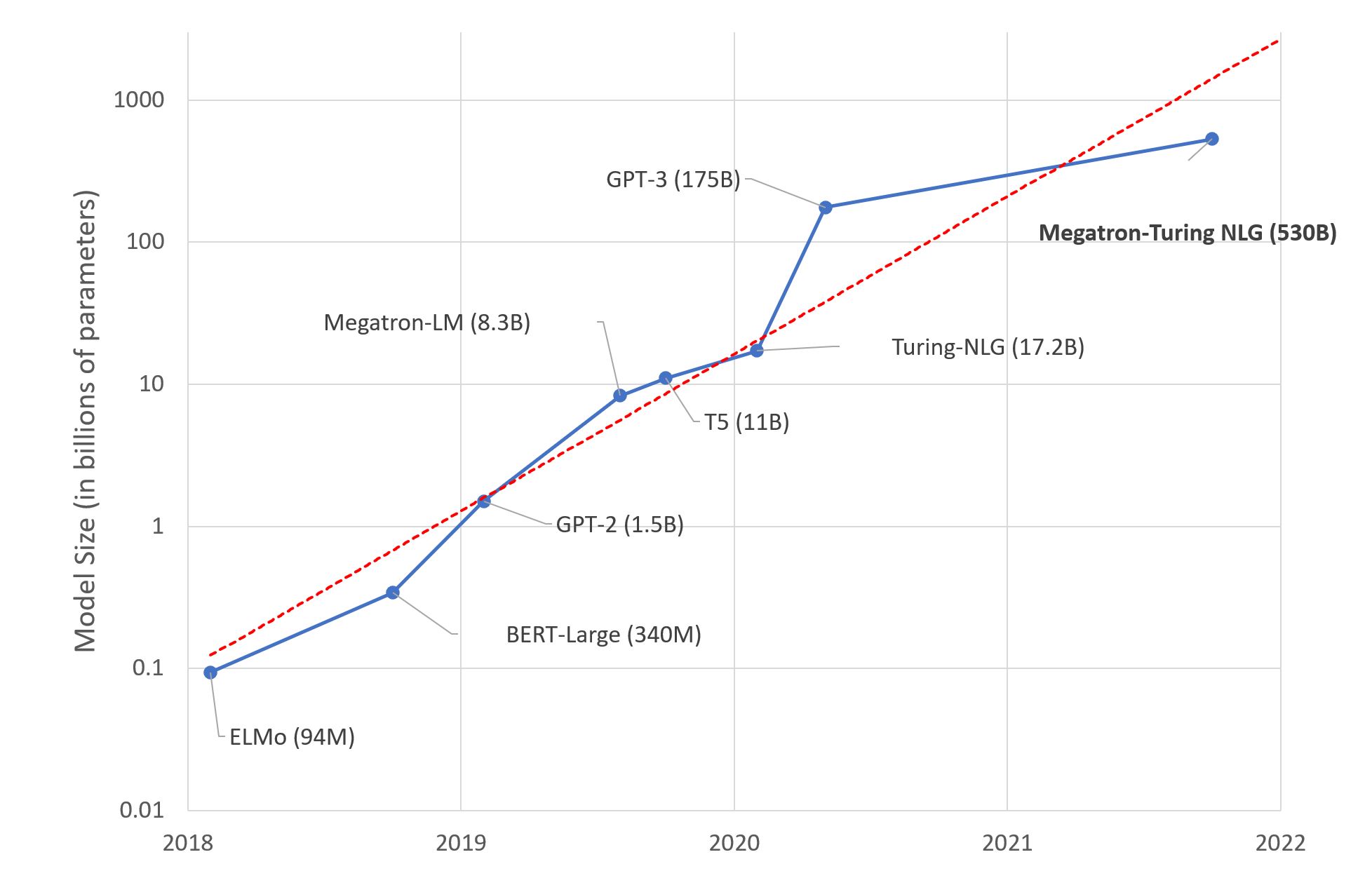

幾天前,微軟和英偉達推出了 Megatron-Turing NLG 530B,這是一款基於 Transformer 的模型,被譽為“世界上最大、功能最強大的生成式語言模型”。

毫無疑問,這是一場令人印象深刻的機器學習工程展示。然而,我們應該對這種巨型模型趨勢感到興奮嗎?就我個人而言,我不以為然。原因如下。

深度學習對你大腦的影響

研究人員估計,人腦平均包含860 億個神經元和 100 萬億個突觸。可以肯定的是,並非所有這些都專門用於語言。有趣的是,GPT-4 預計將擁有約 100 萬億個引數……儘管這個類比很粗糙,我們難道不應該思考,構建與人腦大小差不多的語言模型,這是否是最佳的長期方法?

當然,我們的大腦是一個奇妙的裝置,是數百萬年進化的產物,而深度學習模型才幾十年的歷史。儘管如此,我們的直覺應該告訴我們,有些東西不合邏輯(雙關語)。

深度學習,深不見底?

正如你所預料的,在龐大的文字資料集上訓練一個 5300 億引數的模型需要相當多的基礎設施。事實上,微軟和英偉達使用了數百臺 DGX A100 多 GPU 伺服器。每臺伺服器售價 199,000 美元,再加上網路裝置、託管成本等,任何想要複製這項實驗的人都將花費近 1 億美元。想要搭配薯條嗎?

說真的,哪些組織有商業用例能夠證明在深度學習基礎設施上花費 1 億美元是合理的?甚至 1000 萬美元?很少。那麼,這些模型究竟是為誰而生的呢?

那股暖意是你的 GPU 叢集

儘管工程技術精湛,但在 GPU 上訓練深度學習模型仍是一種蠻力技術。根據規格表,每臺 DGX 伺服器最高可消耗 6.5 千瓦的功率。當然,你的資料中心(或伺服器機櫃)需要至少同等容量的冷卻能力。除非你是史塔克家族的人,需要在冬天保持臨冬城溫暖,否則你將不得不處理另一個問題。

此外,隨著公眾對氣候和社會責任問題的意識日益增強,組織需要對其碳足跡負責。根據馬薩諸塞大學 2019 年的這項研究,“在 GPU 上訓練 BERT 大致相當於一次跨美洲的飛行”。

BERT-Large 有 3.4 億個引數。人們只能推斷 Megatron-Turing 的足跡可能有多大……認識我的人不會稱我為多愁善感的環保主義者。然而,有些數字是難以忽視的。

所以呢?

我對 Megatron-Turing NLG 530B 以及即將到來的任何巨獸感到興奮嗎?不。我認為(相對較小的)基準改進是否值得增加成本、複雜性和碳足跡?不。我認為構建和推廣這些巨型模型有助於組織理解和採用機器學習嗎?不。

我一直在思考這一切的意義何在。為科學而科學?老派營銷?技術霸權?可能每一點都有一點。那麼,我就讓他們去吧。

相反,讓我專注於實用且可操作的技術,這些技術你們都可以用來構建高質量的機器學習解決方案。

使用預訓練模型

在絕大多數情況下,你不需要自定義模型架構。也許你會想要一個自定義的(這是另一回事),但那裡有龍。僅限專家!

一個好的起點是尋找已針對你正在嘗試解決的任務(例如,總結英文文字)進行預訓練的模型。

然後,你應該快速嘗試一些模型來預測你自己的資料。如果指標告訴你某個模型執行良好,那麼你就完成了!如果你需要更高的準確性,你應該考慮微調模型(稍後會詳細介紹)。

使用更小的模型

在評估模型時,你應該選擇能夠提供所需準確性的最小模型。它將預測更快,並需要更少的硬體資源進行訓練和推理。節儉大有裨益。

這也不是什麼新鮮事。計算機視覺從業者會記得 2017 年 SqueezeNet 問世時,與 AlexNet 相比,模型大小減小了 50 倍,同時達到了或超過了其準確性。那真是太巧妙了!

自然語言處理社群也在進行小型化工作,使用知識蒸餾等遷移學習技術。DistilBERT 可能是其最廣為人知的成就。與原始 BERT 模型相比,它保留了 97% 的語言理解能力,同時模型大小減小了 40%,速度提高了 60%。你可以在這裡嘗試。同樣的方法也應用於其他模型,例如 Facebook 的 BART,你可以在這裡嘗試 DistilBART。

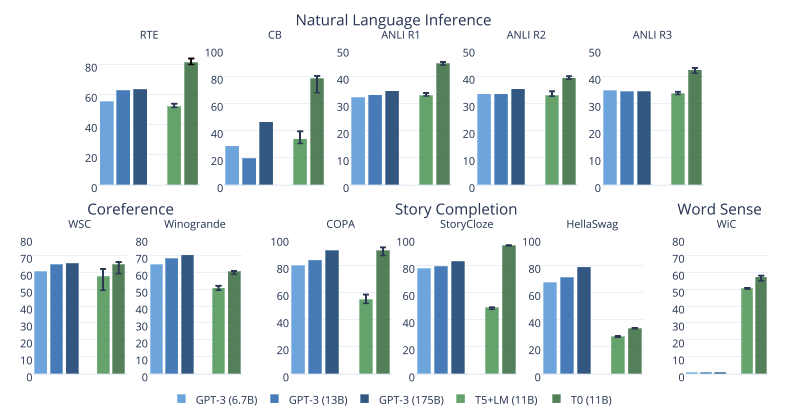

來自 Big Science 專案的最新模型也非常令人印象深刻。如研究論文中所示的圖表,他們的 T0 模型在許多工上都優於 GPT-3,同時模型大小僅為 GPT-3 的 1/16。

你可以在這裡嘗試 T0。這就是我們需要的更多研究!

微調模型

如果你需要專門化模型,幾乎沒有理由從頭開始訓練。相反,你應該微調它,也就是說,只用你自己的資料訓練幾個 epoch。如果你的資料不足,也許這些資料集中的一個可以幫助你入門。

你猜對了,這是另一種進行遷移學習的方式,它將幫助你節省一切!

- 更少的資料收集、儲存、清理和註釋,

- 更快的實驗和迭代,

- 生產中所需的資源更少。

換句話說:省時、省錢、省硬體資源、拯救世界!

如果你需要教程,Hugging Face 的課程將讓你立即入門。

使用基於雲的基礎設施

無論喜歡與否,雲計算公司都知道如何構建高效的基礎設施。可持續性研究表明,基於雲的基礎設施比替代方案更節能和碳效率更高:請參閱 AWS、Azure 和 Google。Earth.org 表示,雖然雲基礎設施並非完美無缺,但“它比替代方案更節能,並促進了環境友好的服務和經濟增長。”

在易用性、靈活性和按需付費方面,雲計算無疑有很多優勢。它也比你想象的更環保一些。如果你的 GPU 不足,為什麼不嘗試在 Amazon SageMaker(AWS 的託管機器學習服務)上微調你的 Hugging Face 模型呢?我們為你準備了大量示例。

最佳化你的模型

從編譯器到虛擬機器,軟體工程師長期以來一直使用工具來自動最佳化其程式碼以適應其執行的任何硬體。

然而,機器學習社群仍然在這個問題上掙扎,而且有充分的理由。最佳化模型的大小和速度是一項極其複雜的任務,涉及以下技術:

- 加速訓練(Graphcore、Habana)和推理(Google TPU、AWS Inferentia)的專用硬體。

- 剪枝:刪除對預測結果影響很小或沒有影響的模型引數。

- 融合:合併模型層(例如,卷積和啟用)。

- 量化:將模型引數儲存為較小的值(例如,8 位而不是 32 位)。

幸運的是,自動化工具開始出現,例如 Optimum 開源庫和 Infinity,這是一種容器化解決方案,可實現 Transformer 的準確性,延遲僅為 1 毫秒。

結論

在過去的幾年裡,大型語言模型的規模每年都在以 10 倍的速度增長。這開始看起來像另一個摩爾定律。

我們以前經歷過這種情況,我們應該知道這條道路會導致收益遞減、成本更高、複雜性增加和新風險。指數增長往往結局不佳。還記得 Meltdown 和 Spectre 嗎?我們想知道這對於人工智慧來說會是什麼樣子嗎?

與其追求萬億引數模型(下注吧),如果我們能構建實用且高效的解決方案,讓所有開發者都能用來解決實際問題,難道不是對所有人都更好嗎?

有興趣瞭解 Hugging Face 如何幫助您的組織構建和部署生產級機器學習解決方案嗎?請透過 julsimon@huggingface.co 聯絡我們(請勿傳送招聘資訊和銷售宣傳)。