程式碼化機器學習時代已來臨

2021 年版的《人工智慧現狀報告》於上週釋出。Kaggle 的《機器學習和資料科學調查報告》也同時釋出。這些報告中有許多值得學習和討論的內容,其中有幾個要點引起了我的注意。

“人工智慧正越來越多地應用於國家電網和疫情期間超市自動化倉儲計算等關鍵任務基礎設施。然而,行業成熟度是否已趕上其日益增長的部署規模,仍是一個疑問。”

不可否認,機器學習驅動的應用程式正在滲透到 IT 的各個角落。但這對於公司和組織意味著什麼?我們如何構建堅如磐石的機器學習工作流?我們都應該僱傭 100 名資料科學家嗎?還是 100 名 DevOps 工程師?

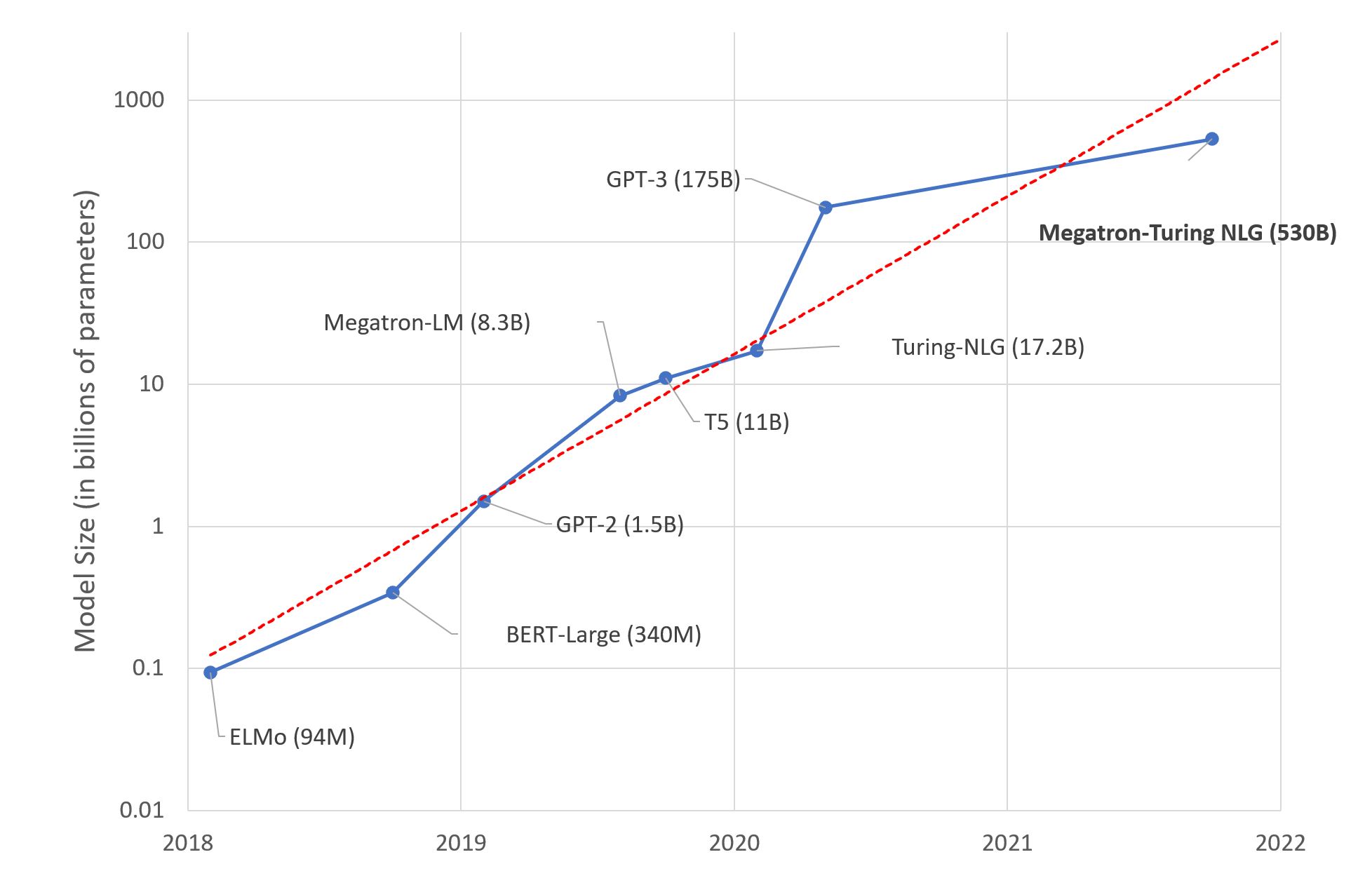

“Transformer 已成為機器學習的通用架構。不僅適用於自然語言處理,還適用於語音、計算機視覺甚至蛋白質結構預測。”

老一輩人已深切體會到,IT 領域沒有銀彈。然而,Transformer 架構確實在各種機器學習任務中表現出色。但我們如何才能跟上機器學習領域瘋狂的創新步伐?我們真的需要專業技能才能利用這些最先進的模型嗎?或者是否存在一條更短的路徑,能在更短的時間內創造商業價值?

嗯,這是我的看法。

全民機器學習!

機器學習無處不在,或者至少它正在努力實現這一點。幾年前,《福布斯》寫道:“軟體吞噬了世界,現在人工智慧正在吞噬軟體”,但這到底意味著什麼?如果這意味著機器學習模型應該取代成千上萬行僵化的遺留程式碼,那麼我完全支援。去死吧,邪惡的業務規則,去死吧!

那麼,這是否意味著機器學習將真正取代軟體工程呢?現在肯定有很多關於人工智慧生成程式碼的幻想,並且一些技術確實很有趣,例如發現錯誤和效能問題。然而,我們不僅不應該考慮擺脫開發者,我們還應該努力賦能儘可能多的開發者,讓機器學習成為又一個無聊的 IT 工作負載(而無聊的技術很棒)。換句話說,我們真正需要的是讓軟體吞噬機器學習!

這次並無不同

多年來,我一直主張並極力強調,幾十年來軟體工程的最佳實踐也適用於資料科學和機器學習:版本控制、可重用性、可測試性、自動化、部署、監控、效能、最佳化等。有段時間我感覺孤立無援,然後谷歌的援軍出乎意料地出現了

“像優秀的工程師一樣做機器學習,而不是像優秀的機器學習專家一樣。”——谷歌《機器學習規則》

也不需要重新發明輪子。DevOps 運動早在 10 多年前就解決了這些問題。現在,資料科學和機器學習社群應該毫不拖延地採納並調整這些經過驗證的工具和流程。這是我們能夠在生產環境中構建健壯、可擴充套件和可重複的機器學習系統的唯一途徑。如果稱之為 MLOps 有助於理解,那也行:我不會為一個新的流行詞爭論。

現在確實是我們停止將概念驗證和沙盒 A/B 測試視為顯著成就的時候了。它們只是通往生產環境的一小步,而生產環境是唯一可以驗證假設和業務影響的地方。每個資料科學家和機器學習工程師都應該致力於儘快、儘可能頻繁地將他們的模型投入生產。**一個尚可的生產模型總是勝過一個優秀的沙盒模型**。

基礎設施?那又怎樣?

現在是 2021 年。IT 基礎設施不應再成為阻礙。軟體早已吞噬了它,透過雲 API、基礎設施即程式碼、Kubeflow 等將其抽象化。是的,甚至在本地也是如此。

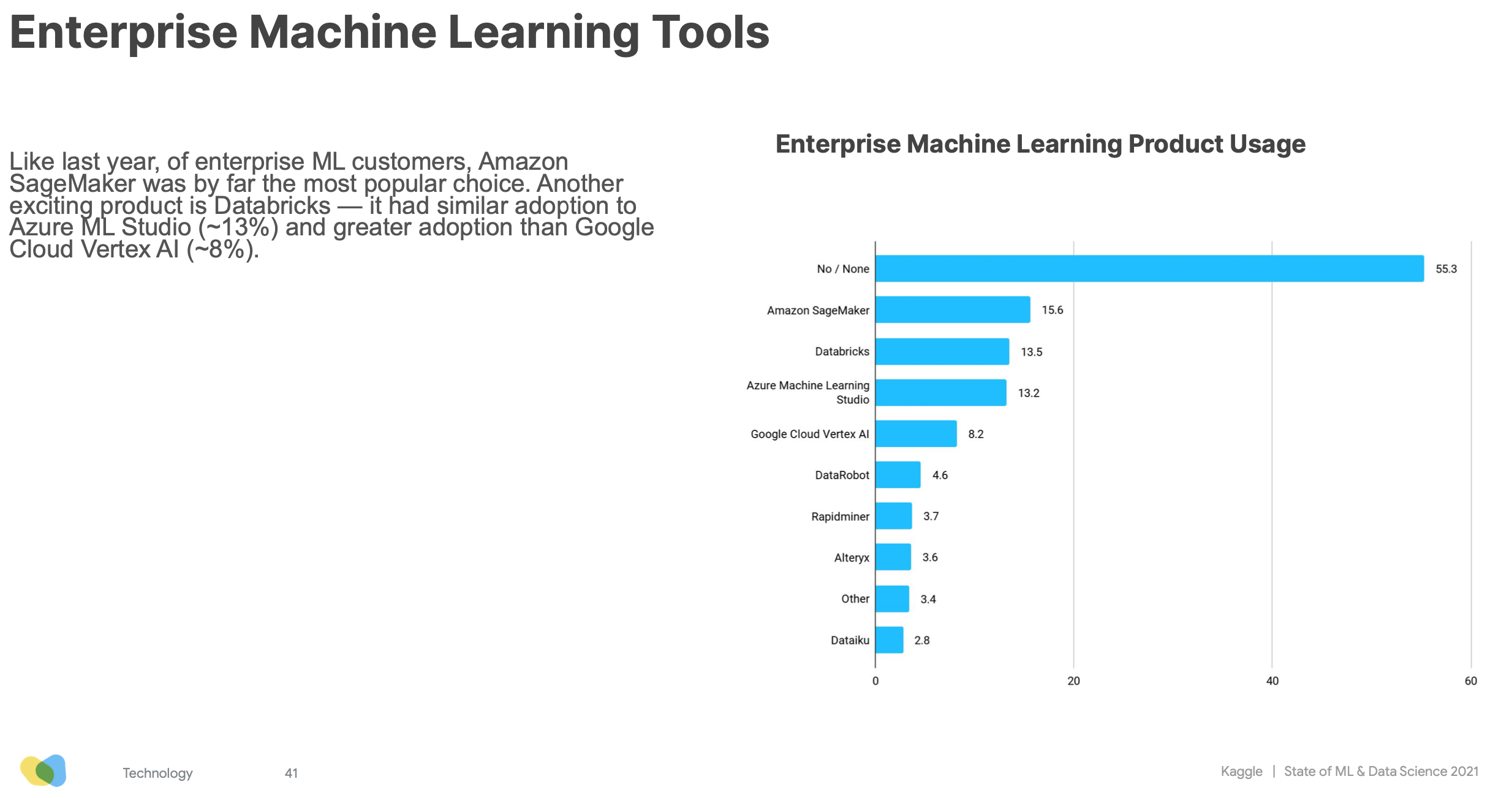

同樣的趨勢也迅速在機器學習基礎設施領域發生。根據 Kaggle 調查,75% 的受訪者使用雲服務,超過 45% 的受訪者使用企業級機器學習平臺,其中 Amazon SageMaker、Databricks 和 Azure ML Studio 位列前三。

有了 MLOps、軟體定義的基礎設施和平臺,將所有這些好主意從沙盒中提取出來並投入生產變得前所未有的容易。為了回答我最初的問題,我很確定你需要僱用更多精通機器學習的軟體和 DevOps 工程師,而不是更多的資料科學家。但內心深處,你早就知道了,對嗎?

現在,我們來談談 Transformer。

Transformers!Transformers!Transformers!(鮑爾默風格)

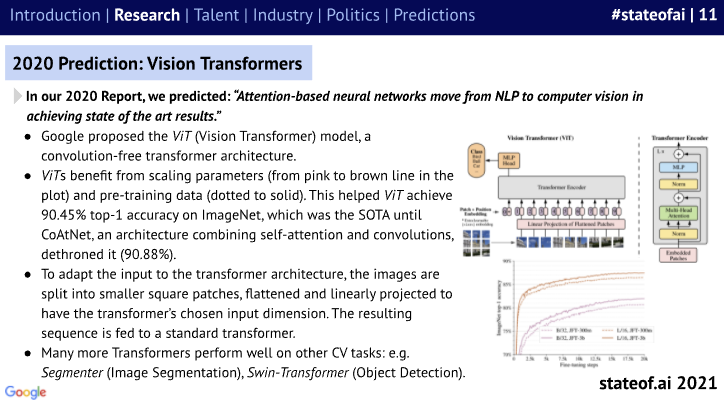

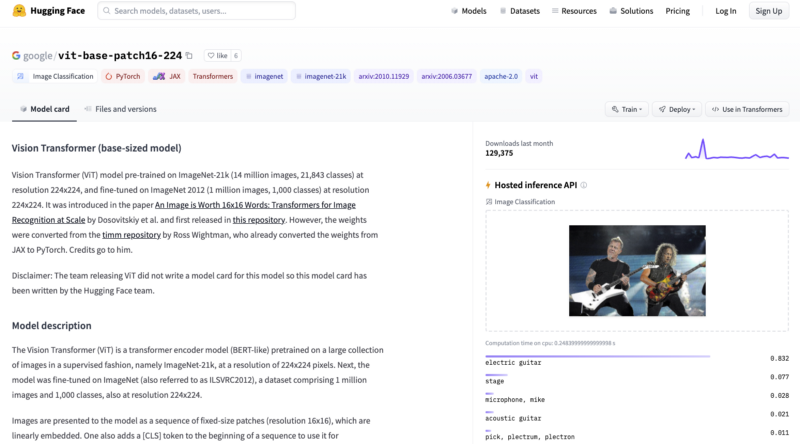

人工智慧現狀報告指出:“Transformer 架構已遠遠超越自然語言處理,正成為機器學習的通用架構。” 例如,最近的模型如谷歌的Vision Transformer(一種無卷積 Transformer 架構)和CoAtNet(融合了 Transformer 和卷積)在 ImageNet 上重新整理了影像分類的基準,同時訓練所需的計算資源更少。

Transformer 在音訊(例如語音識別)以及點雲方面也表現出色。點雲是一種用於對自動駕駛場景等 3D 環境進行建模的技術。

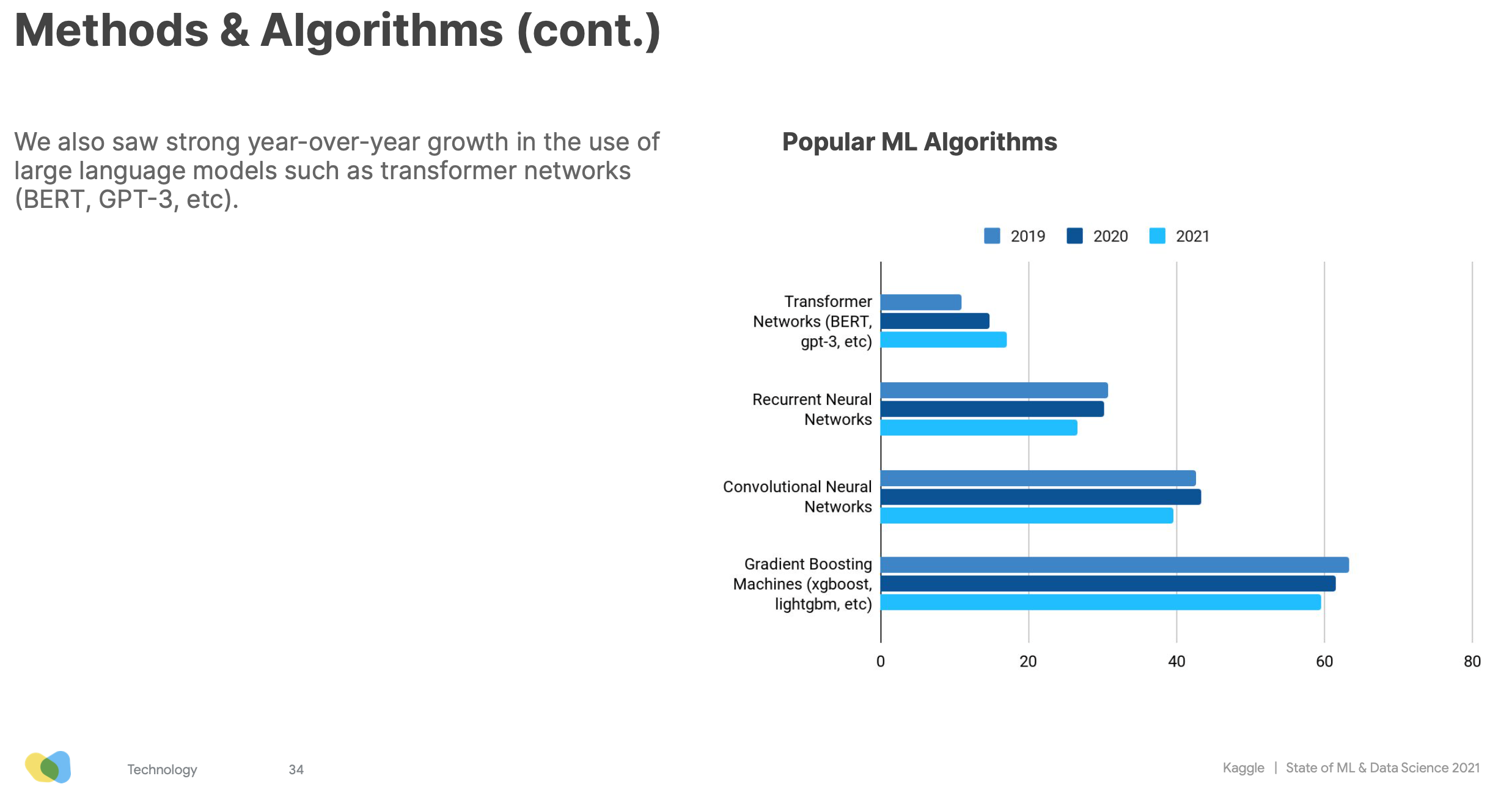

Kaggle 的調查也印證了 Transformer 的興起。其使用量逐年增長,而 RNN、CNN 和梯度提升演算法則在減少。

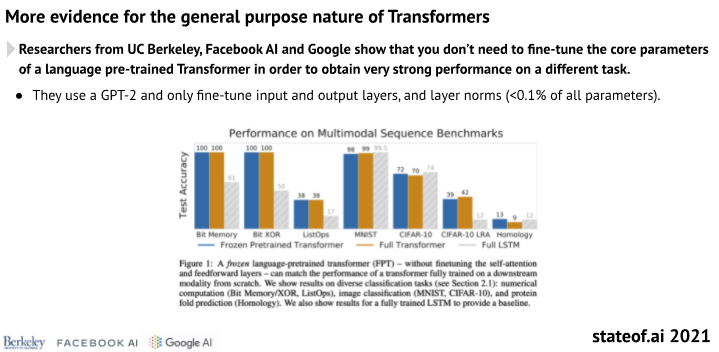

除了提高準確性,Transformer 還不斷實現遷移學習的承諾,使團隊能夠節省訓練時間和計算成本,並更快地交付業務價值。

隨著 Transformer 的出現,機器學習世界正在從“野馬!讓我們從頭開始構建和訓練自己的深度學習模型”逐漸轉向“讓我們選擇一個久經考驗的現成模型,用我們自己的資料進行微調,然後早點回家吃晚飯。”

這在許多方面都是一件好事。最先進的技術不斷進步,幾乎沒有人能跟上其不懈的步伐。還記得我之前提到的 Google Vision Transformer 模型嗎?你想現在就測試一下嗎?有了 Hugging Face,這再簡單不過了。

Big Science 專案的最新零樣本文字生成模型怎麼樣?

您還可以使用另外16,000 多個模型和1,600 多個數據集,以及用於推理、AutoNLP、延遲最佳化和硬體加速的其他工具。我們還可以幫助您啟動專案,。

Hugging Face 的使命是讓機器學習對初學者和專家都儘可能友好和高效。

我們堅信,應儘可能少地編寫程式碼來訓練、最佳化和部署模型。

我們相信內建的最佳實踐。

我們相信基礎設施應儘可能透明。

我們相信,高質量的模型快速投入生產是無與倫比的。

程式碼化機器學習,就在這裡,就在現在!

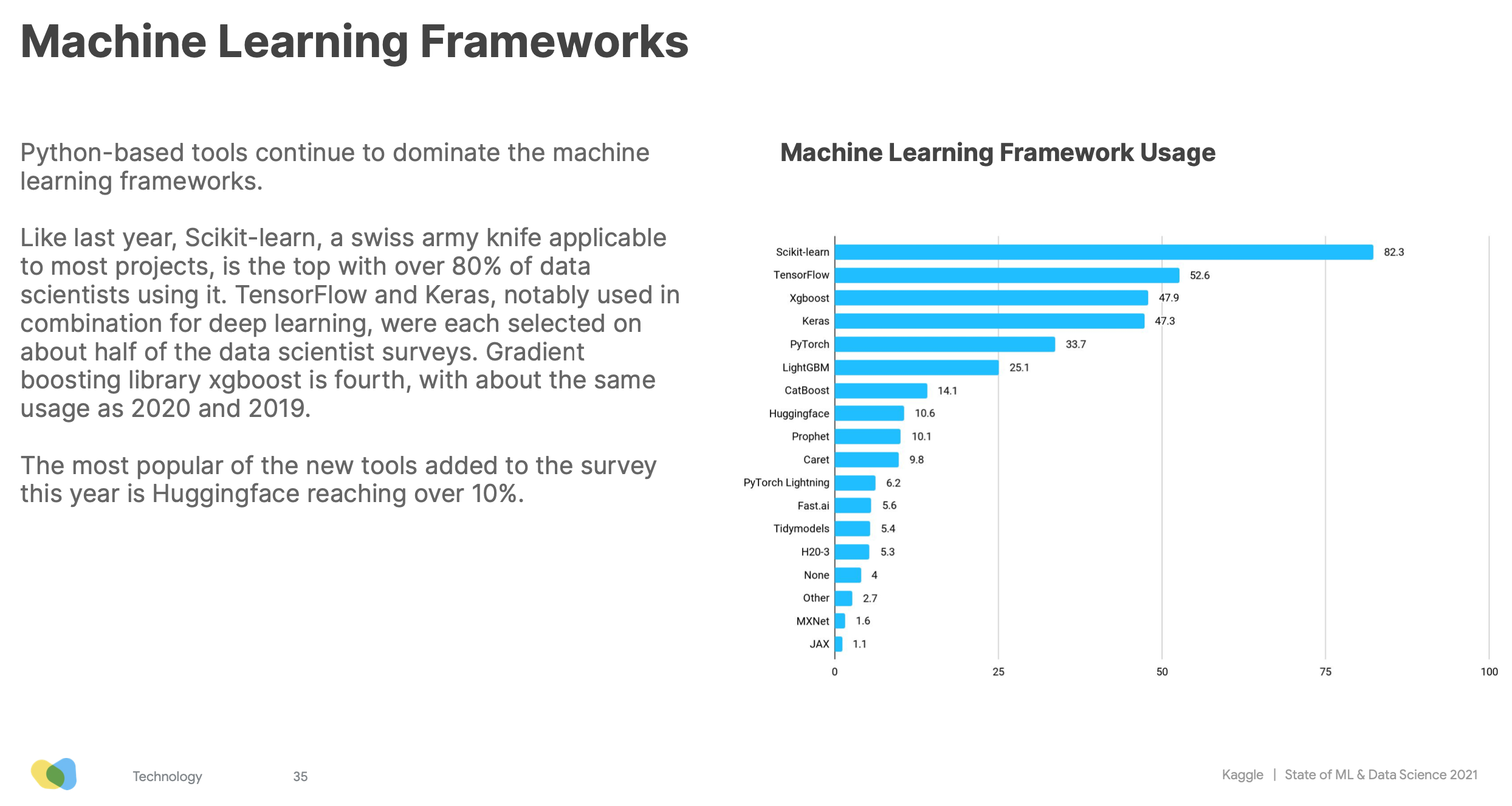

你們中的許多人似乎都同意。我們在 Github 上有超過 52,000 顆星。Hugging Face 首次出現在 Kaggle 調查中,使用率已超過 10%。

感謝大家。是的,我們才剛剛開始。

對 Hugging Face 如何幫助您的組織構建和部署生產級機器學習解決方案感興趣嗎?請聯絡 julsimon@huggingface.co(請勿傳送招聘資訊或銷售推銷)。