TRL 文件

Liger 核心整合

加入 Hugging Face 社群

並獲得增強的文件體驗

開始使用

Liger 核心整合

此部分正在建設中。歡迎貢獻!

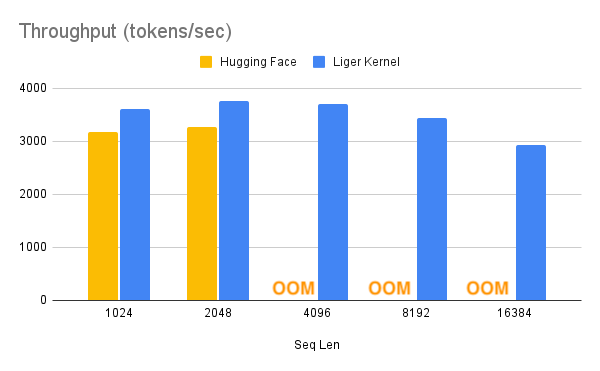

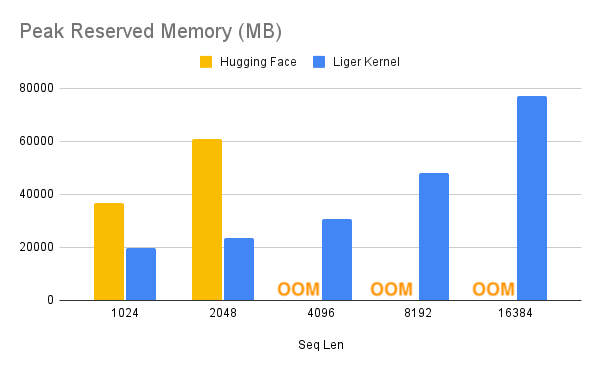

Liger Kernel 是專為 LLM 訓練設計的一系列 Triton 核心。它可以有效將多 GPU 訓練吞吐量提高 20%,並將記憶體使用量減少 60%。這樣,我們就可以將上下文長度增加 4 倍,如下面的基準測試所述。他們已經實現了與 Hugging Face 相容的 RMSNorm、RoPE、SwiGLU、CrossEntropy、FusedLinearCrossEntropy,未來還會有更多。該核心可以與 FlashAttention、PyTorch FSDP 和 Microsoft DeepSpeed 開箱即用。

透過這種記憶體減少,你可能可以關閉 cpu_offloading 或梯度檢查點以進一步提升效能。

| 加速 | 記憶體減少 |

|---|---|

|  |

- 要在 SFTTrainer 中使用 Liger-Kernel,請先透過以下命令安裝它

pip install liger-kernel

- 安裝後,在 SFTConfig 中設定

use_liger_kernel。無需其他更改!

training_args = SFTConfig(

use_liger_kernel=True,

...

)要了解有關 Liger-Kernel 的更多資訊,請訪問其官方倉庫。

< > 在 GitHub 上更新