MCP 課程文件

將 MCP 與本地和開源模型結合使用

並獲得增強的文件體驗

開始使用

將 MCP 與本地和開源模型結合使用

在本節中,我們將使用 Continue(一個用於構建 AI 編碼助手的工具,可與 Ollama 等本地工具配合使用)將 MCP 與本地和開源模型連線起來。

設定 Continue

您可以從 VS Code marketplace 安裝 Continue。

VS Code 擴充套件

- 在 Visual Studio Marketplace 中的 Continue 擴充套件頁面上點選

Install - 這將開啟 VS Code 中的 Continue 擴充套件頁面,您需要再次點選

Install - Continue 標誌將出現在左側邊欄。為了獲得更好的體驗,請將 Continue 移動到右側邊欄

配置好 Continue 後,我們將繼續設定 Ollama 以拉取本地模型。

本地模型

有多種方法可以執行與 Continue 相容的本地模型。三個流行的選擇是 Ollama、Llama.cpp 和 LM Studio。Ollama 是一個開源工具,允許使用者輕鬆在本地執行大型語言模型 (LLM)。Llama.cpp 是一個用於執行 LLM 的高效能 C++ 庫,它還包含一個相容 OpenAI 的伺服器。LM Studio 提供了一個用於執行本地模型的圖形介面。

您可以從 Hugging Face Hub 訪問本地模型,並獲取所有主要本地推理應用程式的命令和快速連結。

Llama.cpp 提供 llama-server,這是一個輕量級、相容 OpenAI API 的 HTTP 伺服器,用於提供 LLM 服務。您可以按照 Llama.cpp 倉庫中的說明從原始碼構建,或者如果您的系統有預構建的二進位制檔案,則可以使用預構建的二進位制檔案。有關更多資訊,請檢視 Llama.cpp 文件。

一旦您擁有 llama-server,您就可以使用以下命令執行 Hugging Face 中的模型:

llama-server -hf unsloth/Devstral-Small-2505-GGUF:Q4_K_M

Continue 支援各種本地模型提供程式。除了 Ollama、Llama.cpp 和 LM Studio,您還可以使用其他提供程式。有關支援的提供程式的完整列表和詳細配置選項,請參閱 Continue 文件。

重要的是,我們使用的模型需要內建工具呼叫功能,例如 Codestral Qwen 和 Llama 3.1x。

- 在工作區頂層建立一個名為

.continue/models的資料夾 - 在此資料夾中新增一個檔案以配置您的模型提供程式。例如,

local-models.yaml。 - 根據您使用的是 Ollama、Llama.cpp 還是 LM Studio,新增以下配置。

此配置適用於透過 llama-server 提供服務的 llama.cpp 模型。請注意,model 欄位應與您提供的模型匹配。

name: Llama.cpp model

version: 0.0.1

schema: v1

models:

- provider: llama.cpp

model: unsloth/Devstral-Small-2505-GGUF

apiBase: https://:8080

defaultCompletionOptions:

contextLength: 8192 # Adjust based on the model

name: Llama.cpp Devstral-Small

roles:

- chat

- edit預設情況下,每個模型都有一個最大上下文長度,本例中為 128000 個令牌。此設定包括對該上下文視窗的更大使用,以執行多個 MCP 請求,並且需要能夠處理更多令牌。

工作原理

工具握手

工具為模型與外部世界互動提供了一種強大的方式。它們作為 JSON 物件提供給模型,包含名稱和引數模式。例如,一個帶有 filepath 引數的 read_file 工具將使模型能夠請求特定檔案的內容。

以下握手描述了代理如何使用工具:

- 在代理模式下,可用工具隨

user聊天請求一起傳送。 - 模型可以選擇在其響應中包含工具呼叫。

- 使用者授予許可權。如果該工具的策略設定為

Automatic,則跳過此步驟。 - Continue 使用內建功能或提供特定工具的 MCP 伺服器呼叫該工具。

- Continue 將結果傳送回模型。

- 模型響應,可能包含另一個工具呼叫,然後重新開始步驟 2。

Continue 支援多個本地模型提供程式。您可以為不同的任務使用不同的模型,或根據需要切換模型。本節重點介紹本地優先解決方案,但 Continue 確實與 OpenAI、Anthropic、Microsoft/Azure、Mistral 等流行提供程式相容。您也可以執行自己的模型提供程式。

本地模型與 MCP 的整合

現在我們已經設定好一切,讓我們新增一個現有的 MCP 伺服器。下面是一個在您的助手中設定新 MCP 伺服器的快速示例:

- 在工作區頂層建立一個名為

.continue/mcpServers的資料夾 - 在此資料夾中新增一個名為

playwright-mcp.yaml的檔案 - 將以下內容寫入

playwright-mcp.yaml並儲存

name: Playwright mcpServer

version: 0.0.1

schema: v1

mcpServers:

- name: Browser search

command: npx

args:

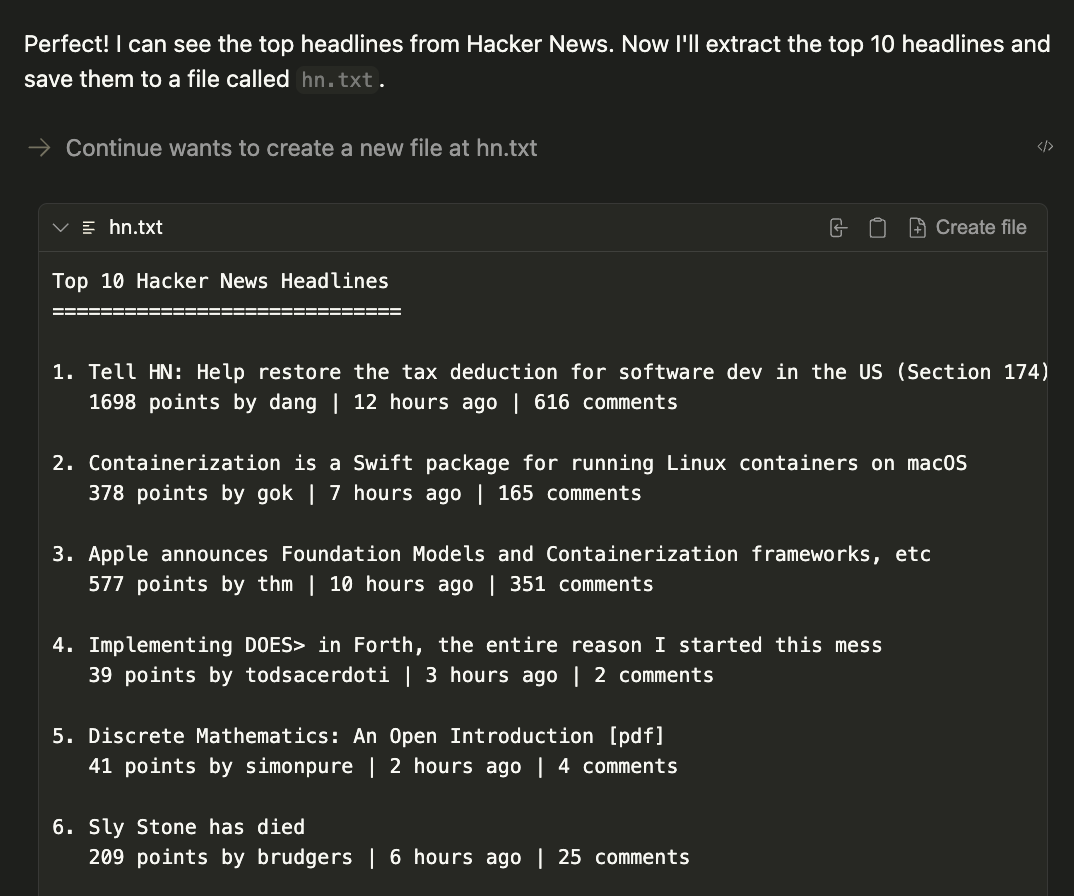

- "@playwright/mcp@latest"現在透過提示以下命令來測試您的 MCP 伺服器

1. Using playwright, navigate to https://news.ycombinator.com.

2. Extract the titles and URLs of the top 4 posts on the homepage.

3. Create a file named hn.txt in the root directory of the project.

4. Save this list as plain text in the hn.txt file, with each line containing the title and URL separated by a hyphen.

Do not output code or instructions—just complete the task and confirm when it is done.結果將在當前工作目錄中生成一個名為 hn.txt 的檔案。

結論

透過將 Continue 與 Llama 3.1 和 MCP 伺服器等本地模型結合使用,您已經解鎖了一個強大的開發工作流,該工作流可以保護您的程式碼和資料隱私,同時利用尖端 AI 功能。

此設定讓您能夠靈活地使用專用工具自定義您的 AI 助手,從網路自動化到檔案管理,所有這些都完全在您的本地機器上執行。準備好將您的開發工作流提升到新的水平了嗎?從 Continue Hub MCP 探索頁面開始嘗試不同的 MCP 伺服器,並發現本地 AI 如何改變您的編碼體驗。

< > 在 GitHub 上更新