推理端點(專用)文件

vLLM

加入 Hugging Face 社群

並獲得增強的文件體驗

開始使用

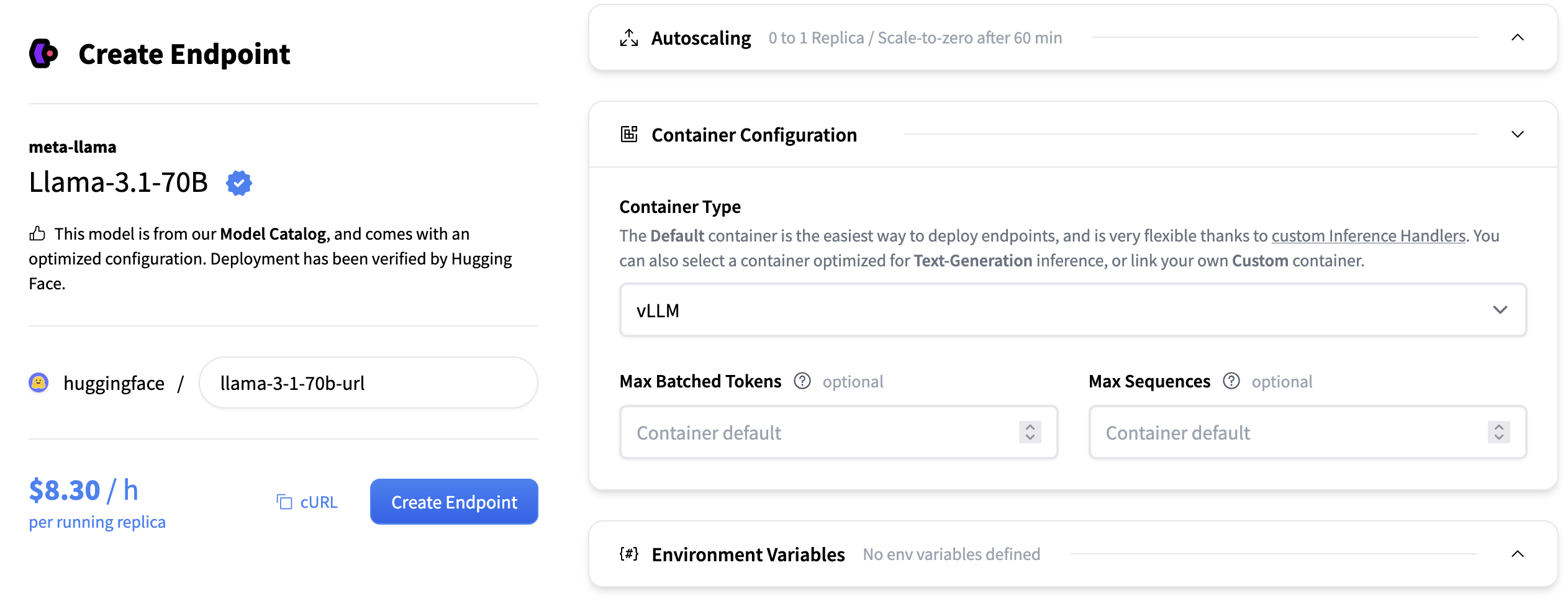

vLLM

vLLM 是一款高效能、記憶體高效的開源大型語言模型推理引擎。它提供高效的排程、KV 快取處理、批處理和解碼功能,所有這些都封裝在一個生產就緒的伺服器中。對於大多數用例,TGI、vLLM 和 SGLang 將是同等優秀的選擇。

核心功能:

- 用於記憶體效率的 PagedAttention

- 連續批處理

- 最佳化的 CUDA/HIP 執行

- 推測解碼與分塊預填充

- 多後端和硬體支援:可在 NVIDIA、AMD 和 AWS Neuron 等平臺上執行

配置

- 最大序列數:單個批次中可同時處理的最大序列(請求)數。它透過序列計數控制批次大小,影響吞吐量和記憶體使用。例如,如果 max_num_seqs=8,則可以同時處理多達 8 個不同的提示,無論它們的單獨長度如何,只要總令牌計數也符合最大批處理令牌數。

- 最大批處理令牌數:單個批次中可處理的最大總令牌數(所有序列的總和)。它透過令牌計數限制批次大小,平衡吞吐量和 GPU 記憶體分配。

- 張量並行大小:模型權重在每個層內分割的 GPU 數量。增加此值可執行更大的模型並釋放 GPU 記憶體用於 KV 快取,但可能會引入同步開銷。

- KV 快取資料型別:用於在生成過程中儲存鍵值快取的資料型別。選項包括“auto”、“fp8”、“fp8_e5m2”和“fp8_e4m3”。使用較低精度型別可以減少記憶體使用,但可能會略微影響生成質量。

對於更高階的配置,您可以將 vLLM 支援的任何引擎引數作為容器引數傳遞。例如,將enable_lora更改為true將如下所示

支援的模型

vLLM 對大型語言模型和嵌入模型提供廣泛支援。我們建議閱讀 vLLM 文件中的支援的模型部分以獲取完整列表。

vLLM 還支援 Transformers 中可用的模型實現。目前並非所有模型都支援,但計劃支援大多數解碼器語言模型和視覺語言模型。

參考資料

我們還建議閱讀vLLM 文件以獲取更深入的資訊。

< > 在 GitHub 上更新